Eu não consigo achar muito coisa quando fazem uma reply a dizer "LOL.", portanto dizer que eu errei... é estranho. Também não quero bulhas, coloquei só a source da informação para suportar o que disse: um burburinho sobre a AMD e a portátil da Nintendo.

Mas lá fizeste um post mais elaborado (tou a brincar).

Sei que não queres bulhas, mas estava apenas a distanciar-me o mais possivel de uma. Não é suposto um moderador andar a começar confusão e não era esse o meu entuito. Além de que não sou moderador aqui.

Percebo de onde estás a vir, também não gosto que me façam um reply a dizer "LOL", mas o meu post, não começou nem acabou aí. Estava a haver uma linha de raciocinio, por assim dizer, embora a interacção com o teu post tenha sido essa, o reasoning para o LOL estava no resto do texto.

Não é o que escreveste que estava errado, eu sei que esses burburinhos, e é provável que a AMD esteja a tentar - até pode ser verdade um dia (eles têm vantagem face à Qualcomm, Nvidia, Adreno e PowerVR's, mas... o track record não é fantástico.

Facto é que a Nintendo é uma empresa caprichosa cujos interesses frequentemente não são os da AMD.

... Raios, a 3DS é mais potente do que a Nintendo tinha em mente - só foram tão alto nos specs por causa do 3D a vontade deles era downclock porque as is a bateria da 3DS não dura tanto como gostariam (ironicamente, muito por causa do power draw do ecrã quando em modo 3D).

Não foi só pelo facto de um VP vir a publico dizer isto, porque é estranho já que, tal como disseste, isto anda tudo a passar-se em background com várias partes interessadas - até a Qualcomm fez propostas para a PS4 e Xbox One, portanto imagino que façam para uma portátil da Nintendo.

Sabes que a Qualcomm fazer propostas para esse segmento não é tão "out-there" como possas pensar (já lá vou), de facto, se a AMD quer a Nintendo como cliente e a Nintendo começar a trabalhar em software para o hardware deles então a Qualcomm é sem duvida o maior risco para, no final, a consola não ser AMD coisa nenhuma.

1. Consolas caseiras (PS3, PS4... possivelmente Wii U?) a consolas portáteis (3DS, PSVita) preferencialmente usam OpenGL ES, não OpenGL normal.

2. A Qualcomm tem herança ATi, especificamente:

(...) chip maker AMD is looking to boost its bottom line by ridding itself of some of the leftovers from its acquisition of ATI – specifically, the hand-held graphics division.

The Imageon-branded OpenGL ES 2.0 hardware the division created (...) was based around the Unified Shader Architecture that the company used in the Xbox 360's graphics hardware.

(...) he company has agreed to sell Imageon to telecommunications chip specialists Qualcomm for $65 million. An early licensee of the technology, Qualcomm will also be taking AMD's hand-held division employees to help it get the most from the platform.

Fonte:

http://www.bit-tech.net/news/2009/01/21/amd-sells-hand-held-division/1

Vantage point: A Qualcomm pode fazer GPU's compativeis com R600 sem pagar um tostão à AMD, a arquitectura que eles usam é um fork relativamente recente da AMD. De facto, é VLIW5, tal como a X360, R600, R700, R800 e a maior parte das R900 (e as R900 que não são VLIW5 são VLIW4), consegue ser mais similar com a Wii U que uma arquitectura GCN.

Caso a Microsoft quisesse retrocompatibilidade e manter a corrida aberta não era uma opção a desperdiçar. E caso a Wii queira manter a concorrencia aberta... Também. Além de que sendo a 3DS um GPU da DMP diria que a DMP nunca está fora do mapa para um follow-up, facilidade de assegurar retrocompatibilidade perfeita.

Não acredito que o pitch tenha ido longe, no entanto. Para a Nintendo e se as ideias de "ecosistema similar" entre consola caseira e portatil forem para cumprir... A Qualcomm é uma hipótese e pode até ser hipótese para as duas.

Depois a NVIDIA fez, há uns meses, declarações que não tem interesse no mercado das consolas (se bem que foi mais damage control do que outra coisa).

Isso nem damage control foi. Foi exasperante.

se calhar não fui claro no post anterior, o queria dizer é que até agora a única coisa que a AMD podia oferecer a nível de core CPU era x86, e que devido às questões do licenciamento eles certamente não podem licenciar a terceiros, não podendo fazer aquilo que Nintendo queria, se bem que também não vejo qual o interesse da Nintendo no x86, sendo o ARM mais interessante.

Mas agora que a AMD já tem uma licença de arquitectura da ARM, estando a trabalhar num custom core o K12, e tendo o seu próprio IP gráfico (GCN, VLIW4 e VLIW5), tal já pode ser possível.

Sim, isso é possível dependendo de quando se materialize, caso haja um alinhamento pode fazer sentido para ambas.

Mas a Nintendo é a empresa que gosta de andar umas revisões de CPU para trás... A DS saiu em 2004 com um ARM9 e um ARM7, já haviam ARM11 há dois anos, a 3DS saiu com um dual core ARM11 (um processador de 2002), quando já haviam Cortex-A8's e Cortex-A9's (a Vita tem 4xA9's).

Há várias razões para isto, não oficiais mas obvias.

1. Licenciamento de arquitecturas mais antigas é sempre mais barato.

2. Arquitecturas antigas são frequentemente menos complexas (core dies mais pequenos face ao tamanho dos transistores), isto também significa que tendem a gastar menos energia quando a usarem o mesmo processo de fabrico que tecnologia mais moderna. Como referir que os Intel Atom são baseados no Pentium 1,

in-order-execution olé. Não é só a Nintendo que vê mérito em ir pescar a baús.

3. Estes SOC's são custom por isso não há vantagem "off-the-shelf" de custos de fabrico em usar a revisão da arquitectura que tem mais tiragem, vai custar o mesmo senão mais (vai custar mais, pela já referida complexidade acrescida).

4. Linhas de produção Foundry que não produzem em processos de linha da frente tipo 22nm para baixo não são as mais procuradas em 2014 mas continuam em operação para fins de "legacy" estas linhas de produção são muito mais baratas à hora. A Nintendo raramente faz core shrinks e é por isto, esmagadora maioria das vezes não lhes compensa a nivel de custos.

Se calhar têm um ARM11 customizado a comer a mesma energia que um ARM A9, mas é vida. Teóricamente, gastaria menos energia se usasse o mesmo processo. Há um balanço, mas ninguém fora da Nintendo o compreende.

Muito menos concordar, raios,.. Eu compreendo e em muitas circunstancias não concordo.

Agora claro que entre aquilo que a AMD pede e aquilo que Nintendo está disposta a pagar, isso são outros 500.

Pior é a AMD aceitar que a Nintendo quer o GPU que eles desenharam capaz de fazer brilharetes de meia noite @ 1 GHz, com metade da complexidade, e a.. 266 MHz.

E isso (apesar de eu estar a exagerar) é provável.

O DMP PICA200 da 3DS foi concebido, finalizado e apresentado em 2006 com dois specs, um @ 400 MHz (fabricado @ 65nm), "high performance" e outro @ 200 MHz, "low performance". Na 3DS, lançada em 2011... Está a 133 MHz.

Fala-se que poderá estar a 266 MHz na New 3DS.

PS: esta conversa até está a ser bastante interessante e tal, e não sou eu o moderador, mas na volta isto já está a ser um pouco off-topic, não? Na volta talvez fosse melhor criar um tópico para o Semi-custom business da AMD.

Ah... Eu não sou moderador aqui...

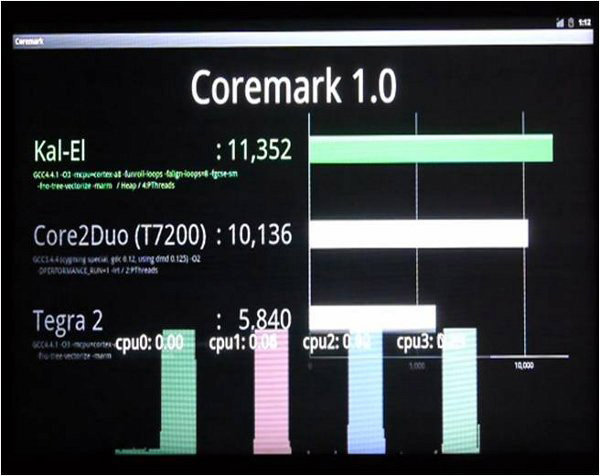

A Intel está sempre à frente, seja em termos reais ou forjados:

Tal como a Nvidia:

Compilaram e optimizaram o bench para a cena deles, usaram um compilador antigo para o Core 2 Duo.

Mas elas todas mentem para ficarem melhor na foto, umas mais que outras. Facto é que relativo à AMD infelizmente não têm tido de mentir.