O DGFF ainda é suportado nos Latitude, pelo menos no ultimo modelo que vi.

A questão não é tanto essa. Devia-me ter explicado melhor, porque os maiores problemas não estão explicados naquele artigo.

Initial reports claimed it to be a proprietary solution that Dell wanted to push to consumers and OEMs for those lucrative royalty fees, but there’s more to the story than that.

It’s worth noting that CAMM utilizes the same DRAM ICs as found on SODIMM modules but with a different interface to the PCB. Thus, it is this interface that makes CAMM special and the heart of the patents under Dell.

This is where it gets tricky. Unlike SODIMM modules, CAMM modules will be different in size depending on the RAM capacity. For example, two 16 GB SODIMM modules are the same size as two 8 GB SODIMM modules, but one 32 GB CAMM module may be longer or wider than one 16 GB CAMM module.

Dell says their specific dimensions have yet to be determined as the CAMM design standards are still a work in progress.

Though CAMM is shorter in Z, it can be larger in X and Y when compared to SODIMM depending on the capacity. It may therefore not be possible to upgrade a CAMM laptop from 16 GB to 32 GB or 64 GB if there is not enough space on the motherboard to support the physically larger CAMM modules. How much physical room is available to upgrade will likely depend on the laptop maker. In fact, OEMs will likely have to redesign entire motherboards around the new CAMM standard since current designs are so optimized around SODIMM; you can’t just swap out SODIMM for CAMM like you would for a yearly CPU update, for example.

Dell says there will only be one CAMM module connection per motherboard whereas laptops utilizing SODIMM can have up to four. This will pose a challenge to end-user upgrades as the original CAMM module would have to be removed completely when upgrading. For example, a laptop with two SODIMM slots and one 8 GB RAM module can be upgraded to 16 GB by simply adding a second 8 GB module. On a CAMM laptop, however, the original 8 GB CAMM module must be replaced completely with a 16 GB CAMM module.

Dell says CAMM modules at this point in time cost $1 more per GB to produce than standard SODIMM modules.

https://www.notebookcheck.net/CAMM-memory-preview-The-Dell-SODIMM-revolution.658666.0.html

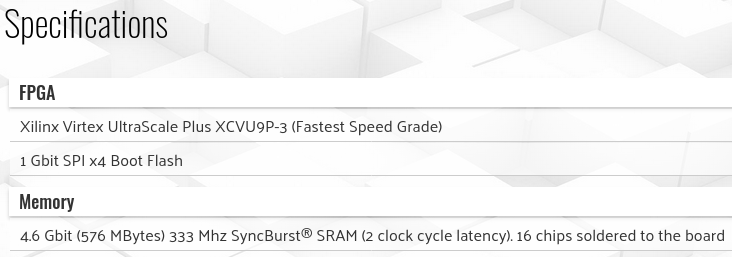

Uninstalling the CAMM module is straightforward; it lifts out after removing six screws. Below you can see the compression connector.

https://www.storagereview.com/review/dell-camm-dram-the-new-laptop-standard

Primeiro que tudo, eu nem sei se este formato é uma boa ideia. A Dell tem as patentes e vai pedir royalties. As dimensões fisicas são diferentes consoante a quantidade de RAM que cada placa tem. Só há 1 ligação/placa. Tens 16 GB de RAM e queres colocar 32 GB? Deitas fora os 16 GB de RAM e coloca-se os 32 GB no total.

Segundo, eles lançaram um produto para o mercado com um formato que ainda nem tem as dimensões físicas definidas. Isto é, alguém com um portátil lançado agora pode-se ver na situação do seu CAMM modulo ter dimensões físicas diferentes dos CAMM módulos que se tornam standard.

O ultimo artigo diz que o upgrade é "straightforward", logo seguido de que é preciso tirar e voltar a colocar 6 parafusos.

É comparar como se trocam SODIMMs hoje em dia.

Por ultimo, suporte ECC não está implementado. Neste ponto reparar que eles lançaram este formato na gama "Precision" que é a gama de Workstations.

Eu sei que há standards que não começaram por ser standards e devido à sua popularidade, tornaram-se standard, mas parece-me que deveria haver um "trabalho mínimo" já feito, quando se lança um produto para o mercado consumidor. Por exemplo, ter as dimensões físicas estabelecidas.

E isto vai ter aos problemas que já se levantaram com o DGFF. Promessas iniciais de "upgrades", mas a coisa foi tão mal feita, que tiveram que voltar com a palavra atrás em certos casos.

Certo tinha esquecido que GPU quer BW over latency.

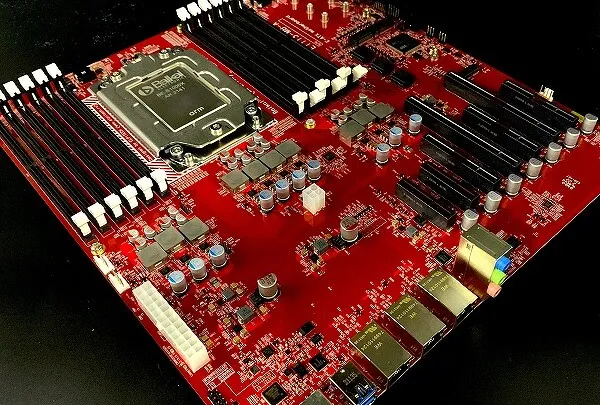

Poderia ser implementado como cache L4 numa board "server class" ? Ou dado o tamanho gigante do EPYC, colocar esta L4 no package, comunicando pelo IO e acessivel por todos os cores.

Já está implementado com o 3DVCache, como L3 e a solução da AMD deve ser mais fácil de atingir bons números de performance e provavelmente mais barata, porque os Chips de SRAM estão mais "próximos" dos chips de Compute. Isto é, ficam fisicamente por cima dos chips de compute e por isso, estão no mesmo package.

A única vantagem que vejo, naquela solução daquela placa, é que é capaz de ser mais barato, rápido de implementar e mais flexível em produtos que tenham números de produção baixos.