z3r0agp

Power Member

Para quando a release date em PT das GTX295 single pcb? Alguem sabe?

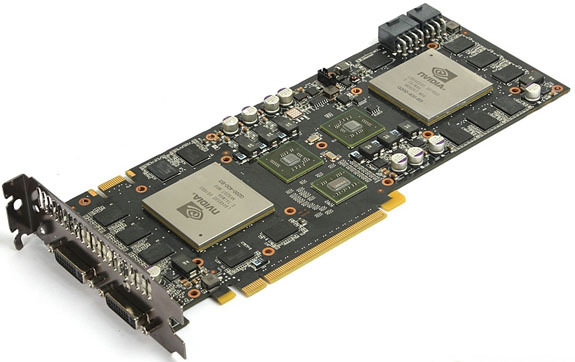

Gostava de saber a data de lançamento.. Tou á espera de uma 295 normal á 1 mes para trocar a minha 9800gx2 que deu o berro. As 295 normais tao esgotadas e penso que seja devido a estas estarem prestes a sair.

Pelo que li a preço vai ser o mesmo. As GTX295 normais sao muito caras de fabricar e nvidia tinha pouca margem de lucro. Entao estas novas GTX295 veem ao mesmo preço, mas com mais lucro para a nvidia

E se os ganhos com quad-SLI já são vergonhosos, com 6 então...

E se os ganhos com quad-SLI já são vergonhosos, com 6 então...

mas pronto estou curiosa para ver se esta V2 será igual ao v2 da segunda gerra mundial e levanta voo?

mas pronto estou curiosa para ver se esta V2 será igual ao v2 da segunda gerra mundial e levanta voo?