You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

Microsoft will show DirectX 12 at GDC

- Autor do tópico V1r7u4L

- Data Início

strafejump

Power Member

e isso é novidade? foi assim com a gtx680/770. e ver uma 380x colada a uma 780ti... gostava de ver resultados para a 280x também.

Notarnicola

What is folding?

A r9 380x ao nivel de uma gtx780ti? Tanta difrenca entre gtx780ti e gtx 970.

Alguém para confirmar?

ObscureAngel

I quit My Job for Folding

Não vejo espanto nisso, já a algum tempo que a 970 passava a perna à GTX 780TI em muitos jogos.

Se a 380x tem um bom performance DX12 é normal começar a subir pela lista acima.

Se a 380x tem um bom performance DX12 é normal começar a subir pela lista acima.

Impressionante a 290X, é uma geração que se está a relevar extraordinária, os anos passam e ela continua de muito boa saúde. Faz lembrar os 2500K da Intel, dura, dura e dura...

Com excepção do Pascal, que obviamente já tem outro tipo de optimização, as únicas Nvidia que parecem conseguir segurar-se na frente, mesmo em DX12, async e companhia, é a 980Ti e Titan.

Talvez devido ao tremendo brute force da Ti e Titan, as limitações com a nova API e devidas features, não sobressaiam tanto.

Com excepção do Pascal, que obviamente já tem outro tipo de optimização, as únicas Nvidia que parecem conseguir segurar-se na frente, mesmo em DX12, async e companhia, é a 980Ti e Titan.

Talvez devido ao tremendo brute force da Ti e Titan, as limitações com a nova API e devidas features, não sobressaiam tanto.

Torak

Power Member

A r9 380x ao nivel de uma gtx780ti? Tanta difrenca entre gtx780ti e gtx 970.

Alguém para confirmar?

Em jogos em DX12 e Vulkan este tipo de resultados é bastante comum.

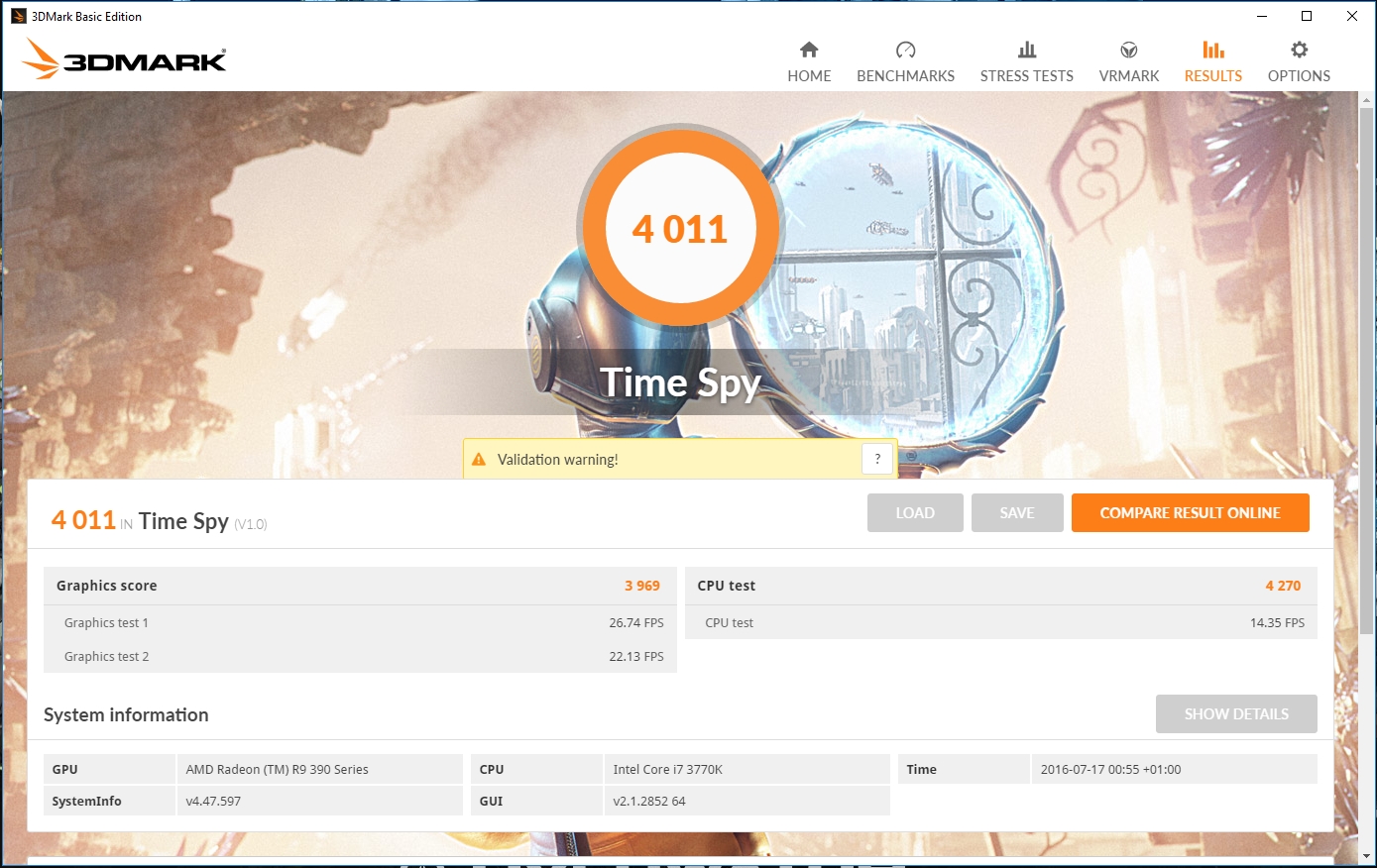

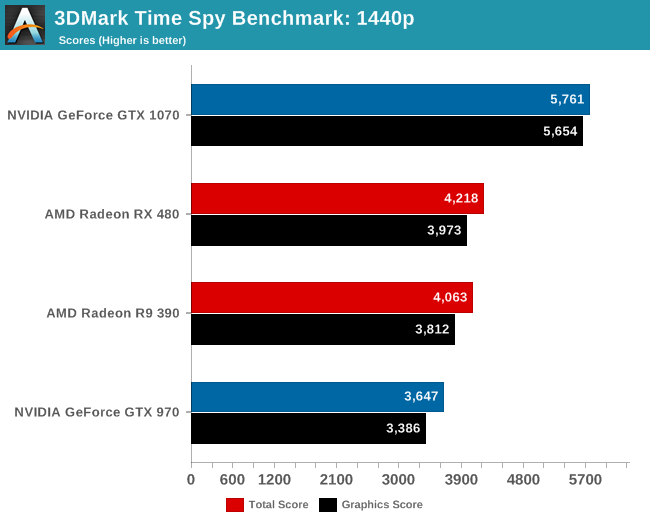

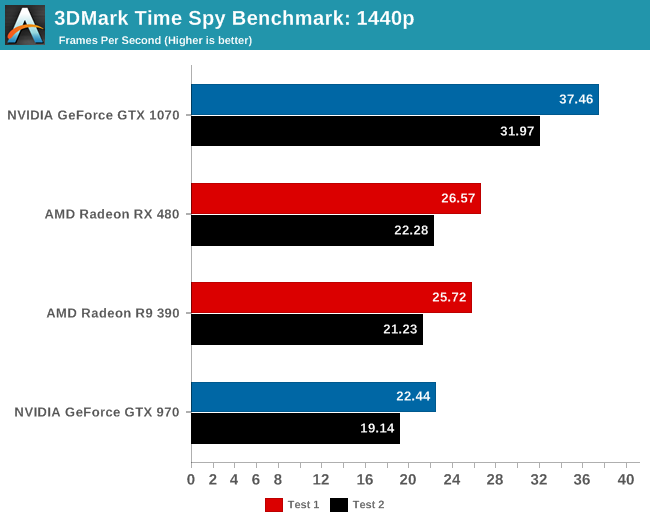

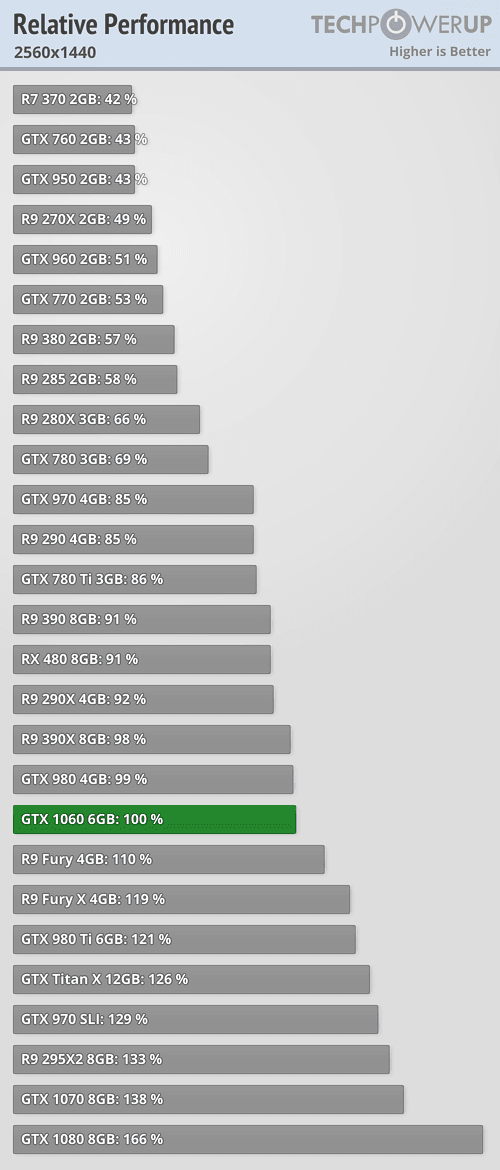

Mas tens aqui mais resultados neste 3DMark, a 1440p.

Já tinham colocado o link no página anterior, para o artigo do PCPER:

Roberto1973

Power Member

Pedro_1

Power Member

Então quer dizer que neste teste, onde se consegue efetivamente usar funcionalidades como async, a 480 está mesmo perto de 980. Parece-me bom, se os jogos começarem a sair a usar este tipo de funcionalidades, talvez vejamos um dx12 com boa performance nas amd, o problema è se saem "meia dúzia" deles assim e o resto ao estilo dx11.

Se a nvidia começa a encher os bolsos das produtoras e estas começarem a meter gameworks e afins, está o caldo entornado.

Continuo a achar o preço demasiado alto cá em Portugal, o argumento sonante nesta placa foram sinceramente os 200 dólares para 4gb, o que era francamente bom. Não só as placas de 4gb são uma miragem, como o preço final na tuga pelo factor novidade se paga de forma severa.

Ouvi algures que o msrp já incluía margem de lucro para o retalhista, se alguém com conhecimento tiver 2 palavras a dizer, agradecia o esclarecimento. É que de 230 dólares para a versão de 8gb, mesmo com o cambio, para os mais de 300 euros para miseras versões reference, acho o preço final abusadamente alto.

Se a nvidia começa a encher os bolsos das produtoras e estas começarem a meter gameworks e afins, está o caldo entornado.

Continuo a achar o preço demasiado alto cá em Portugal, o argumento sonante nesta placa foram sinceramente os 200 dólares para 4gb, o que era francamente bom. Não só as placas de 4gb são uma miragem, como o preço final na tuga pelo factor novidade se paga de forma severa.

Ouvi algures que o msrp já incluía margem de lucro para o retalhista, se alguém com conhecimento tiver 2 palavras a dizer, agradecia o esclarecimento. É que de 230 dólares para a versão de 8gb, mesmo com o cambio, para os mais de 300 euros para miseras versões reference, acho o preço final abusadamente alto.

Última edição:

Torak

Power Member

Segundo a id software, não tens motivos para estar preocupado:

id Software: Async Compute will be a major factor in all engines across all platforms

id Software: Async Compute will be a major factor in all engines across all platforms

“Doom is already a clear example where async compute, when used properly, can make drastic enhancements to the performance and look of a game. Going forward, compute and async compute will be even more extensively used for idTech6. It is almost certain that more developers will take advantage of compute and async compute as they discover how to effectively use it in their games.”

“Vulkan actually has pretty decent tools support with RenderDoc already and the debugging layers are really useful by now. The big benefit of Vulkan is that shader compiler, debug layers and RenderDoc are all open source. Additionally, it has full support for Windows 7, so there is no downside in OS support either compared to DX12.”

“From a different perspective, I think it will be interesting to see the result of a game entirely taking advantage by design of any of the new APIs – since no game has yet. I’m expecting to see a relatively big jump in the amount of geometry detail on-screen with things like dynamic shadows. One other aspect that is overlooked is that the lower CPU overhead will allow art teams to work more efficiently – I’m predicting a welcome productivity boost on that side.”

Pedro_1

Power Member

É isso. È o mínimo que eles podem fazer è utilizar os recursos disponíveis. Não só è bom para o consumidor porque os jogos saem bem otimizados, como eles se quiserem podem dar um bump no detalhe, tal como referido.

Ninguém fica a perder, pode se calhar dar mais trabalho na programação, a utilização de features avançadas, mas o resultado final è mais gratificante. E ainda estou para ver mais jogos alêm do AOS utilizarem gpu´s diferentes como um único. Já vimos que a tecnologia trabalha e escala surpreendentemente bem. Quero ver agora este exemplo ser seguido, ou será que isso foi usado apenas para propaganda e fica por ali??? è muito mau se isso acontecer pois demonstra nitidamente que ninguém está virado em agarrar e utilizar a ferramentas disponibilizadas.

Ninguém fica a perder, pode se calhar dar mais trabalho na programação, a utilização de features avançadas, mas o resultado final è mais gratificante. E ainda estou para ver mais jogos alêm do AOS utilizarem gpu´s diferentes como um único. Já vimos que a tecnologia trabalha e escala surpreendentemente bem. Quero ver agora este exemplo ser seguido, ou será que isso foi usado apenas para propaganda e fica por ali??? è muito mau se isso acontecer pois demonstra nitidamente que ninguém está virado em agarrar e utilizar a ferramentas disponibilizadas.

Torak

Power Member

Já agora, sobre a importância do Async compute, deixo uma citação da entrvista do DF ao pessoal da id:

Digital Foundry: Can you go into depth on the wins asynchronous compute gave you on the consoles and any differential there between PS4 and Xbox One?

Jean Geffroy: When looking at GPU performance, something that becomes quite obvious right away is that some rendering passes barely use compute units. Shadow map rendering, as an example, is typically bottlenecked by fixed pipeline processing (eg rasterization) and memory bandwidth rather than raw compute performance. This means that when rendering your shadow maps, if nothing is running in parallel, you're effectively wasting a lot of GPU processing power.

Even geometry passes with more intensive shading computations will potentially not be able to consistently max out the compute units for numerous reasons related to the internal graphics pipeline. Whenever this occurs, async compute shaders can leverage those unused compute units for other tasks. This is the approach we took with Doom. Our post-processing and tone-mapping for instance run in parallel with a significant part of the graphics work. This is a good example of a situation where just scheduling your work differently across the graphics and compute queues can result in multi-ms gains.

This is just one example, but generally speaking, async compute is a great tool to get the most out of the GPU. Whenever it is possible to overlap some memory-intensive work with some compute-intensive tasks, there's opportunity for performance gains. We use async compute just the same way on both consoles. There are some hardware differences when it comes to the number of available queues, but with the way we're scheduling our compute tasks, this actually wasn't all that important.

Pedro_1

Power Member

Coversa interessante entre o Ryan e um dos engenheiros chefe da futuremark, acerca da implementação do asyn no time spy, do futuro do async, e das possíveis semelhanças entre o async implementado neste momento no teste, com o futuro de como irá ser implementada esta funcionalidade em futuros jogos dx12 etc...

Pelo que percebo pela conversa, no futuro, iremos ver resultados algo semelhante ao time spy, no sentido que não deveremos ver a fotografia por exemplo no hitman, ou do quantum break, onde existe um claro favorecimento a arquitetura cgn e a esta funcionalidade. Pela conversa os resultados deveram ser mais parcidos entre ambas e os devs iram seguir alguns dos passos que a futuremark segue em time spy. Ele diz que é uma espécie de previsão.

Recomendo o vídeo, desmente alguns dos boatos.

Torak

Power Member

Desde o 3DMark 2003 que não faltam problemas e polémicas com esta saga de benchmarks.

E tendo em conta que é um benchmark sintético cujo motor gráfico é usado e quase aldo nenhum, não se justifica continuarem a dar-lhe importância.

Felizmente já há muitos sites que há muitos anos deixaram de usar este programa em análises de gráficas. Só é pena que outros sites, alguns de renome, continuem a usar esta coisa.

E tendo em conta que é um benchmark sintético cujo motor gráfico é usado e quase aldo nenhum, não se justifica continuarem a dar-lhe importância.

Felizmente já há muitos sites que há muitos anos deixaram de usar este programa em análises de gráficas. Só é pena que outros sites, alguns de renome, continuem a usar esta coisa.

Miguel_Pereira

Power Member

Concordo com que o 3dmark é polémico, mas apesar de tudo dá valores consistentes. Se em 3dmark a GPU X for 10% melhor que a GPU Y, isso tem sido mais ou menos representado num lote de jogos. Acho que para uma ideia generalista continua a ser uma ferramenta razoável para posicionamento de mercado de gráficas.

Miguel_Pereira

Power Member

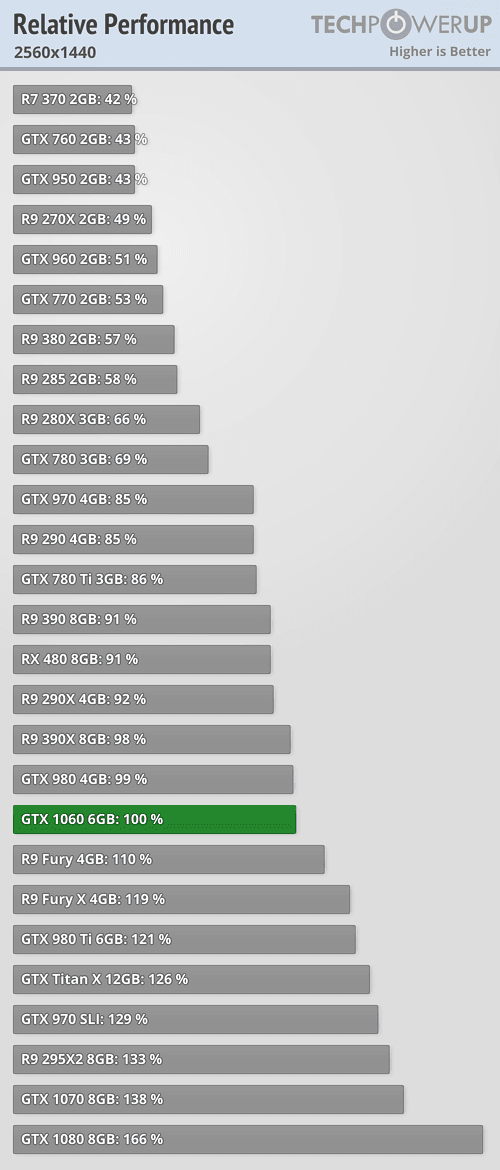

Eu disse indicativo. Olha aqui duas imagens de websites de reviews diferentes (dos mais credíveis, diria). Salvo diferenças de 2-3%, no geral o 3dmark indica a posição relativa de performance das GPU's com relativa certeza.

Ou seja, para uma analise simples, dá uma boa ideia do posicionamento de determinada gráfica.

Ou seja, para uma analise simples, dá uma boa ideia do posicionamento de determinada gráfica.

Torak

Power Member

Sim, o score é consistente, mas não significa que representa a realidade, pois não é um motor gráfico usado em jogos.

Nem mesmo entre gráficas de fabricantes e gerações diferentes, acaba por mostrar pouco da realidade.

Quem quer saber qual é a melhor gráfica para jogar, o ideal é ver testes de jogos reais e não o 3DMark.

Esta questão da falta de optimização em DX12 do TimeSpy apenas vem mostrar mais uma vez que este benchmark é uma valente treta.

Já vai mais de uma década que começaram as polémicas com esta série e continuam em boa ritmo.

Nem mesmo entre gráficas de fabricantes e gerações diferentes, acaba por mostrar pouco da realidade.

Quem quer saber qual é a melhor gráfica para jogar, o ideal é ver testes de jogos reais e não o 3DMark.

Esta questão da falta de optimização em DX12 do TimeSpy apenas vem mostrar mais uma vez que este benchmark é uma valente treta.

Já vai mais de uma década que começaram as polémicas com esta série e continuam em boa ritmo.

brruno

Banido

@Torak

Como exactamente é que é consistente e ao mesmo tempo não representa a realidade ?

Eu acho é que não viste bem as imagens .. A primeira é uma media dos resultados em jogos ..

E se olhares para a segunda, do 3D mark, não foge muito.

i.e. embora o 3D mark não seja um motor de jogo usado em jogos, o 3D mark têm resultados semelhante ao que acontece em média nos jogos..

Como exactamente é que é consistente e ao mesmo tempo não representa a realidade ?

Eu acho é que não viste bem as imagens .. A primeira é uma media dos resultados em jogos ..

E se olhares para a segunda, do 3D mark, não foge muito.

i.e. embora o 3D mark não seja um motor de jogo usado em jogos, o 3D mark têm resultados semelhante ao que acontece em média nos jogos..