You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

R520 - Benchmarks

- Autor do tópico Nemesis11

- Data Início

Rudzer

Power Member

ptzs disse:O Ratzinger dos slides contra-ataca!

(por acaso têm info porreira no meio da propaganda toda)

o problema é que muita gente não sabe tirar/filtrar a palha (maior parte)

ptzs

Power Member

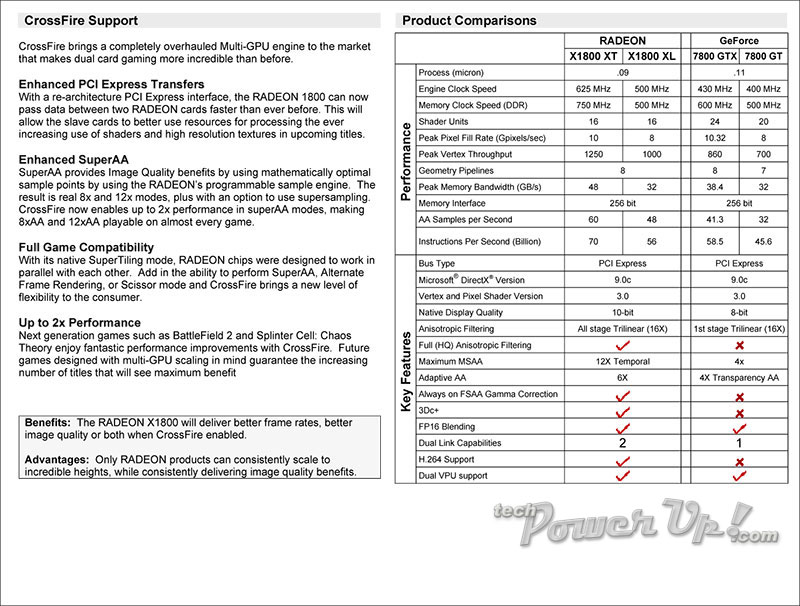

destr0yer disse:E diz que as 7800 não fazem decode H.264, não foi isso que eu ouvi.

Desde as 80.40 (30 de junho) que a série 7800 ajuda no decode de H.264.

Última edição:

blastarr

Power Member

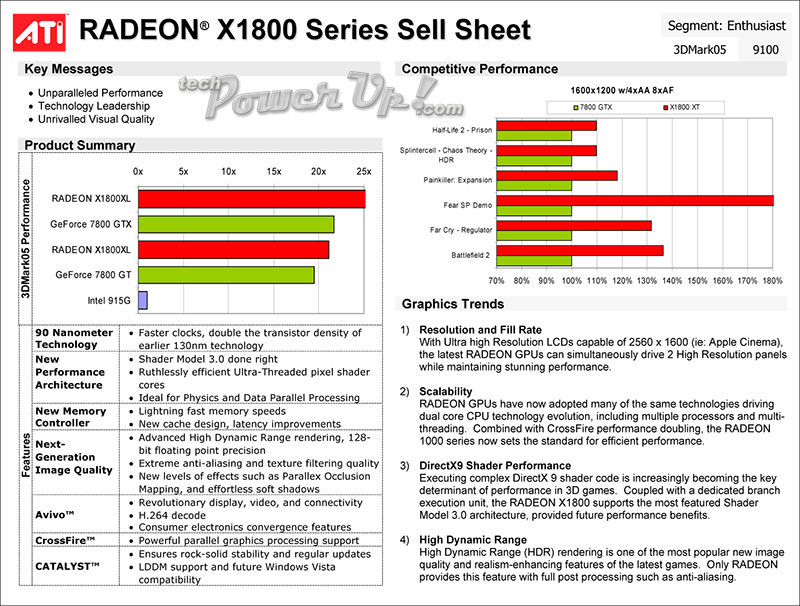

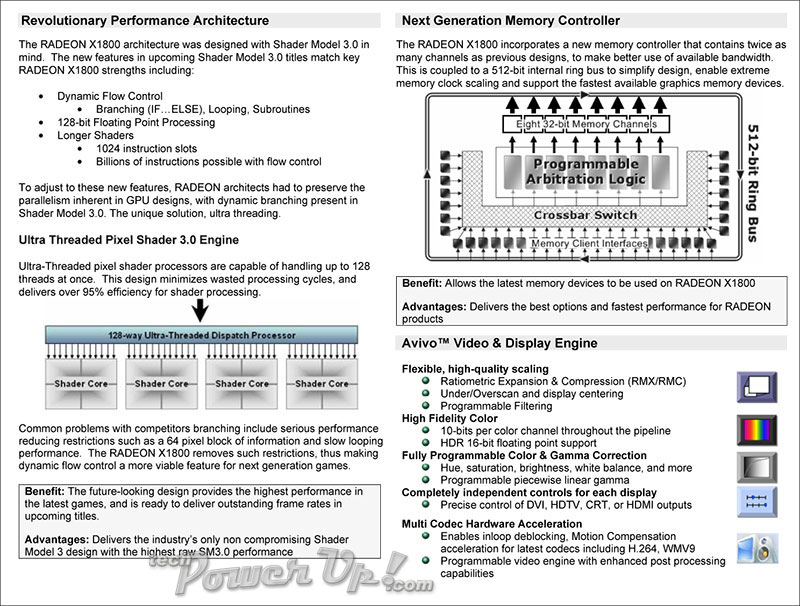

Gráficos com escalas a começar em 70 e a acabar em 180, não dizem que drivers são usados, os clocks das placas, quanta memória (se for uma versão de 512Megas da R520 contra uma versão de 256Megas da GTX, com tudo ao máximo, claro que há penalização, mas quero ver a comparação com a G7... que vai sair em novembro e que também tem 512MB), quais as plataformas, não explicam como é tão potente se supostamente tem o FP32 sempre activo, o render-to-vertex buffer (um formato de HDR) não faz parte do DX9c, como tal é inútil e não será aproveitado por muitos jogos, não apresentam nada no feature set para além do SM 3.0, dizem que são os primeiros a 90nm e o primeiro foi o Geforce 61xx, o H.264 é acelerado (e bem) nas geforce 6150, e geforce 6 e 7 com os drivers 80.40, 81.26 e 81.33, não falam do facto do Ultra-Threaded Processor ser o mesmo que a Nvidia estreou nas GeforceFX, o mesmo conceito embora com um nome diferente e performances supostamente diferentes, não falam no consumo de energia, na disponibilidade real no mercado das placas high-end, ou mesmo das outras, etc, etc.

Diria que a Nvidia teve toda a razão em cancelar a Ultra e acelerar a G80, what for, right ?

Enfim, eu espero pelos benchs a sério...

Edit: esqueci-me de dizer que o 3Dc também existe nas Geforce 6/7, basta um ligeiro hack do registry.

Diria que a Nvidia teve toda a razão em cancelar a Ultra e acelerar a G80, what for, right ?

Enfim, eu espero pelos benchs a sério...

Edit: esqueci-me de dizer que o 3Dc também existe nas Geforce 6/7, basta um ligeiro hack do registry.

Última edição:

Rudzer

Power Member

blastarr disse:Gráficos com escalas a começar em 70 e a acabar em 180, não dizem que drivers são usados, os clocks das placas, quanta memória (se for uma versão de 512Megas da R520 contra uma versão de 256Megas da GTX, com tudo ao máximo, claro que há penalização, mas quero ver a comparação com a G7... que vai sair em novembro e que também tem 512MB), quais as plataformas, não explicam como é tão potente se supostamente tem o FP32 sempre activo, o render-to-vertex buffer (um formato de HDR) não faz parte do DX9c, como tal é inútil e não será aproveitado por muitos jogos, não apresentam nada no feature set para além do SM 3.0, dizem que são os primeiros a 90nm e o primeiro foi o Geforce 61xx, o H.264 é acelerado (e bem) nas geforce 6150, e geforce 6 e 7 com os drivers 80.40, 81.26 e 81.33, não falam do facto do Ultra-Threaded Processor ser o mesmo que a Nvidia estreou nas GeforceFX, o mesmo conceito embora com um nome diferente e performances supostamente diferentes, não falam no consumo de energia, na disponibilidade real no mercado das placas high-end, ou mesmo das outras, etc, etc.

Diria que a Nvidia teve toda a razão em cancelar a Ultra e acelerar a G80, what for, right ?

Enfim, eu espero pelos benchs a sério...

Edit: esqueci-me de dizer que o 3Dc também existe nas Geforce 6/7, basta um ligeiro hack do registry.

Estavas à espera do que de marketing-slides...

blastarr disse:Gráficos com escalas a começar em 70 e a acabar em 180, não dizem que drivers são usados, os clocks das placas, quanta memória (se for uma versão de 512Megas da R520 contra uma versão de 256Megas da GTX, com tudo ao máximo, claro que há penalização, mas quero ver a comparação com a G7... que vai sair em novembro e que também tem 512MB), quais as plataformas, não explicam como é tão potente se supostamente tem o FP32 sempre activo, o render-to-vertex buffer (um formato de HDR) não faz parte do DX9c, como tal é inútil e não será aproveitado por muitos jogos, não apresentam nada no feature set para além do SM 3.0, dizem que são os primeiros a 90nm e o primeiro foi o Geforce 61xx, o H.264 é acelerado (e bem) nas geforce 6150, e geforce 6 e 7 com os drivers 80.40, 81.26 e 81.33, não falam do facto do Ultra-Threaded Processor ser o mesmo que a Nvidia estreou nas GeforceFX, o mesmo conceito embora com um nome diferente e performances supostamente diferentes, não falam no consumo de energia, na disponibilidade real no mercado das placas high-end, ou mesmo das outras, etc, etc.

Diria que a Nvidia teve toda a razão em cancelar a Ultra e acelerar a G80, what for, right ?

Enfim, eu espero pelos benchs a sério...

Edit: esqueci-me de dizer que o 3Dc também existe nas Geforce 6/7, basta um ligeiro hack do registry.

amém!

Já se sabe que as marcas puxam a brasa a sua sardinha, já a nvidia tb naqueles slides também exagerou uma beka...

Última edição:

DJ_PAPA

Power Member

O lançamento oficial é dia 5, por isso falta pouco mais que 1 dia.

Quanto a features:

- 10bits color é muito bom (quem nao se lembra da Matrox com 10bit color).

- O uso do FP32 sempre activo la por nao ser suportado agora, ira ser suportado por um proximo Direct_X e isso é sempre bom.

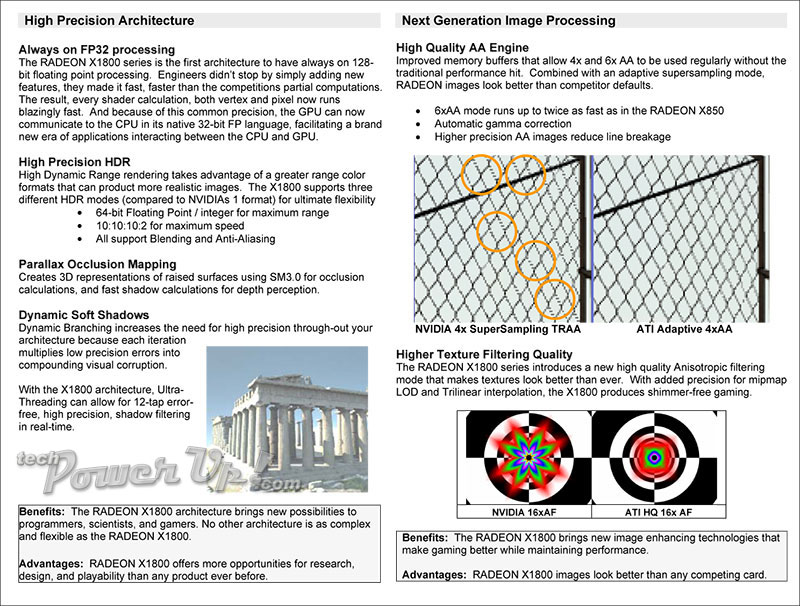

- Os novos modos de AA e AF estao ao nivel dos da Nvidia, senao superiores. Nomeadamente no AF com todos os estagios em triliniar e o Full HQ aniso.

- O uso de 3 tipos diferentes de HDR vai permitir adaptar o HDR ao jogo em questao e verificar qual se adapta melhor e com 128bits FP precision.

- O uso de dual link capability com uso de 2 paineis em altas resoluçoes até 2550*1600

Depois o proprio uso do SM3, do decode de H.264 e o novo 3Dc+.

E por ultimo a adiçao de novos tweaks como threads in order, 512bits internal bus e a nova organizaçao das caches que vao permitir aumentar o desempenho.

O melhor é isto tudo tar disponivel em toda a gama desde o high ao low-end.

Quanto a features:

- 10bits color é muito bom (quem nao se lembra da Matrox com 10bit color).

- O uso do FP32 sempre activo la por nao ser suportado agora, ira ser suportado por um proximo Direct_X e isso é sempre bom.

- Os novos modos de AA e AF estao ao nivel dos da Nvidia, senao superiores. Nomeadamente no AF com todos os estagios em triliniar e o Full HQ aniso.

- O uso de 3 tipos diferentes de HDR vai permitir adaptar o HDR ao jogo em questao e verificar qual se adapta melhor e com 128bits FP precision.

- O uso de dual link capability com uso de 2 paineis em altas resoluçoes até 2550*1600

Depois o proprio uso do SM3, do decode de H.264 e o novo 3Dc+.

E por ultimo a adiçao de novos tweaks como threads in order, 512bits internal bus e a nova organizaçao das caches que vao permitir aumentar o desempenho.

O melhor é isto tudo tar disponivel em toda a gama desde o high ao low-end.

Rudzer

Power Member

DJ_PAPA disse:O melhor é isto tudo tar disponivel em toda a gama desde o high ao low-end.

Isso não serve de muito, visto as placas low-end não terem "pujança" para correr nada que tire partido das novas tecnologias (mais ver o exemplo de dar Pixel Shader a placas de baixa gama

)

)HDR com placas low-end deve ser pior que slide-shows...lol

blastarr

Power Member

Adianta muito ter Dual-link DVI com 10 bits de cor, quando a esmagadora maioria dos LCD's não dá mais de 8bit, sendo muitos deles de 6bit para diminuir a latência.

E sim, nós sabemos o que aconteceu à Matrox, que aínda hoje cobra um balúrdio por tecnologia 2D de 2001...

Por alguma razão a Nvidia só incorpora essa feature nas QuadroFX.

No mercado normal encontrar displays com 10bit por pixel é como procurar uma agulha (e bem cara) num palheiro.

E sim, nós sabemos o que aconteceu à Matrox, que aínda hoje cobra um balúrdio por tecnologia 2D de 2001...

Por alguma razão a Nvidia só incorpora essa feature nas QuadroFX.

No mercado normal encontrar displays com 10bit por pixel é como procurar uma agulha (e bem cara) num palheiro.

|Oc|CRASH_OVer

Suspenso

SKATAN disse:-Ideal for physics and data parallel processing

me coça a cabeça !

..É algo que a ATI tambem ja referiu á uns bons meses atrás sobre a R500 da X360

DJ_PAPA

Power Member

Nao sei até que ponto os 10bits de côr podem melhorar a qualidade mesmo em paineis inferiores.

É possivel que mesmo em paineis mais baratos se notem diferenças.

Publicidade da Matrox Pharphelia sobre o giga-color:

http://www.matrox.com/mga/products/parhelia512/technology/gigacolor.cfm

É possivel que mesmo em paineis mais baratos se notem diferenças.

Publicidade da Matrox Pharphelia sobre o giga-color:

http://www.matrox.com/mga/products/parhelia512/technology/gigacolor.cfm

Rudzer

Power Member

DJ_PAPA disse:Nao sei até que ponto os 10bits de côr podem melhorar a qualidade mesmo em paineis inferiores.

É possivel que mesmo em paineis mais baratos se notem diferenças.

wtf...e dizes isso baseando-te no que? gezzz

vou esperar por resultados reais. Pra quando os haverá?

vou esperar por resultados reais. Pra quando os haverá?