brruno

Banido

Nas consolas, as várias tecnologias empregues para atingir o 4k, funcionam.(na maior parte das vezes com resultados não perfeitos, mas satisfatórios à visão)

No PC, a maior parte dessas tecnologias não são empregues, e quando são, têm resultado sofríveis.(Excetuando o Dlss, claro)

É triste mas é verdade, em PC, por norma, tudo o que não se aproxime de 1800p não parece 4k numa tv 4k.

Um pouco discutivel..

Na grande parte dos casos o upscale das consolas, é "meh". num ou outro é meio decente sim.

Mas seja qual for, acaba sempre por adicionar algum blur ( ou mesmo muito) e artefactos.

Do lado do PC sim, as implemtaçoes tem sido na grande parte fracas, o CAS da AMD é capaz de ser ao equivalente á media do que é feito nas consolas.

O DLSS é mesmo algo a outro nivel, e isso vai ser uma grande vantagem dos PC's em relação ás consolas. Com um PC a usar DLSS a ter igual ou melhor qualidade que uma consola a correr em 4K nativo.

Vai permitir que uma grafica "teoricamente mais fraca" ( TFLOPS) tenha melhor qualidade e performance.

Em relação à primeira será complicado, pois apesar de sabermos que o RT se tornará uma feature de hardware system wide, o dlss é proprietário, não estão reunidas as condições para ser adoptado pela industria.

Não percebi esta frase. Estás a falar de ser adoptado em jogos ? Ou por outro fabricantes ?

A nivel de jogos, diria que mais de metade dos jogos "blockbuster" de 2020 suportam DLSS .

Não é preciso correr em todo e qualquer jogo, basta estas nos mais importantes / mais jogados / mais pesados.

Em relação à segunda, conto com a AMD para isso, não me acredito que a Nividia traga RT e Dlss ao mercado <300€, mas tenho a certeza que a Amd fará pressão e nos dará algo muito interessante no próximo dia 28 de Outubro, principalmente aonde mais interessa, na faixa 250/350€.

Já não sei se for a nVidia que confirmou se foi um leak ; mas que as series 300 vai ser tudo corrido a RTX ( Raytracing + DLSS).

maior competidora da nVidia não é a AMD, é a nVidia.

A nVida tem de incentivar o pessoal com graficas 1000 e anteriores a fazer upgrade, e para isso precisa de lançar hardware que compense a bom preço.

Eles ganham mais €€ a vendar graficas novas em massa do que a vender meia duzias de 3070 a 1000€ ..

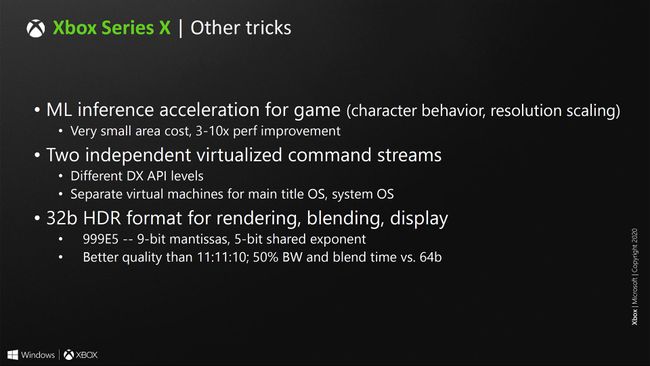

Sim, mas , na minha opinião, dificilmente Apis que mudam aspectos tão fundamentais como o io, resultam sem hardware especifico, atenção, não digo que não funcionem, mas acredito sinceramente que sem hardware capaz, o efeito será quase nulo.

Aliás, acho que o RtxIo, é um bom exemplo da minha percepção.

Ao longo dos anos, o hardware teve sempre de evoluir para acompanhar a evolução do IO, é uma necessidade, o harware é construido com determinadas especificações em mente, se fosse assim tão fácil ainda andávamos com portas vga.

A nivel de grafica tera de ter essa "comptabilidade". Mas não é isso que estou a dizer.

O que estou a dizer é que um estudio que faça um jogo que suporte o directstorage nas consolas suportará automaticamente em Windows com uma grafica com RTX IO . Sem necessidade de andar a progamar para "hardware especifico" .

A API trata disso , e a API é que terrá como requesito ter RTX IO / equivalente